智能知识——深度学习入门必须理解这25个概念(3) 点击:149 | 回复:1

楼主最近还看过

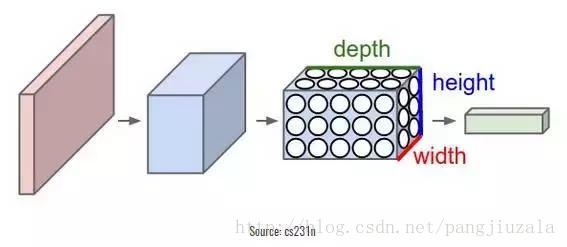

18、卷积神经网络(CNN)——卷积神经网络基本上应用于图像数据。假设我们有一个输入的大小(28 28 3),如果我们使用正常的神经网络,将有 2352(28 28 3)参数。并且随着图像的大小增加参数的数量变得非常大。我们"卷积"图像以减少参数数量(如上面滤波器定义所示)。当我们将滤波器滑动到输入体积的宽度和高度时,将产生一个二维激活图,给出该滤波器在每个位置的输出。我们将沿深度尺寸堆叠这些激活图,并产生输出量。

你可以看到下面的图,以获得更清晰的印象。

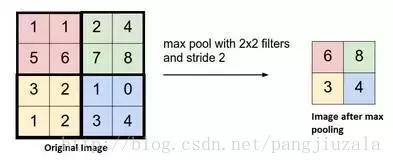

19、池化(Pooling)——通常在卷积层之间定期引入池层。这基本上是为了减少一些参数,并防止过度拟合。最常见的池化类型是使用 MAX 操作的滤波器尺寸(2,2)的池层。它会做的是,它将占用原始图像的每个 4 * 4 矩阵的最大值。

你还可以使用其他操作(如平均池)进行池化,但是最大池数量在实践中表现更好。

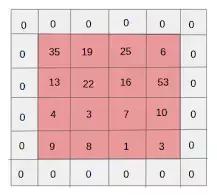

20、填充(Padding)——填充是指在图像之间添加额外的零层,以使输出图像的大小与输入相同。这被称为相同的填充。

在应用滤波器之后,在相同填充的情况下,卷积层具有等于实际图像的大小。

有效填充是指将图像保持为具有实际或"有效"的图像的所有像素。在这种情况下,在应用滤波器之后,输出的长度和宽度的大小在每个卷积层处不断减小。

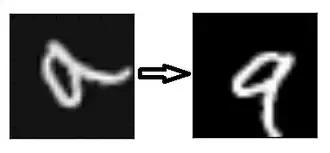

21、数据增强(Data Augmentation)——数据增强是指从给定数据导出的新数据的添加,这可能被证明对预测有益。例如,如果你使光线变亮,可能更容易在较暗的图像中看到猫,或者例如,数字识别中的 9 可能会稍微倾斜或旋转。在这种情况下,旋转将解决问题并提高我们的模型的准确性。通过旋转或增亮,我们正在提高数据的质量。这被称为数据增强。

循环神经网络

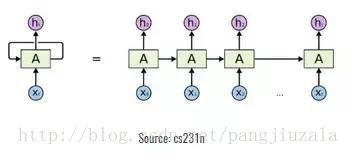

22、循环神经元(Recurrent Neuron)——循环神经元是在 T 时间内将神经元的输出发送回给它。如果你看图,输出将返回输入 t 次。展开的神经元看起来像连接在一起的 t 个不同的神经元。这个神经元的基本优点是它给出了更广义的输出。

23、循环神经网络(RNN)——循环神经网络特别用于顺序数据,其中先前的输出用于预测下一个输出。在这种情况下,网络中有循环。隐藏神经元内的循环使他们能够存储有关前一个单词的信息一段时间,以便能够预测输出。隐藏层的输出在 t 时间戳内再次发送到隐藏层。展开的神经元看起来像上图。只有在完成所有的时间戳后,循环神经元的输出才能进入下一层。发送的输出更广泛,以前的信息保留的时间也较长。

然后根据展开的网络将错误反向传播以更新权重。这被称为通过时间的反向传播(BPTT)。

24、消失梯度问题(Vanishing Gradient Problem)——激活函数的梯度非常小的情况下会出现消失梯度问题。在权重乘以这些低梯度时的反向传播过程中,它们往往变得非常小,并且随着网络进一步深入而"消失"。这使得神经网络忘记了长距离依赖。这对循环神经网络来说是一个问题,长期依赖对于网络来说是非常重要的。

这可以通过使用不具有小梯度的激活函数 ReLu 来解决。

25、激增梯度问题(Exploding Gradient Problem)——这与消失的梯度问题完全相反,激活函数的梯度过大。在反向传播期间,它使特定节点的权重相对于其他节点的权重非常高,这使得它们不重要。这可以通过剪切梯度来轻松解决,使其不超过一定值。

- 步进电机拆卸方法

[748]

[748] - <智能制造>知识----<智能制造...

[1317]

[1317] - 全面解析物联卡,这些关于物联...

[1729]

[1729] - 有关OPCUATSN的一些常见问题

[880]

[880] - 【案例】电气标准化实施分享

[992]

[992] - 8倍提速,欧姆龙抑振成功案例...

[1129]

[1129] - 智能制造之路:共享经济的春风...

[809]

[809] - 无负压供水中的威格派双向补...

[710]

[710] - 智慧路灯带来的产业变革有哪...

[1193]

[1193] - 图说GIS-----GIS变电站

[700]

[700]

官方公众号

智造工程师

-

客服

客服

-

小程序

小程序

-

公众号

公众号

工控网智造工程师好文精选

工控网智造工程师好文精选