LabVIEW利用Monte Carlo 工业数据模拟应用 点击:152 | 回复:0

基于LabVIEW 平台,结合 NI 工业级硬件构建 Monte Carlo 模拟系统,实现工业传感器数据不确定性分析与设备故障概率预测。通过图形化编程架构与高性能硬件协同,解决复杂工业场景下的随机问题量化分析需求,适用于智能制造、能源监控等领域的可靠性评估与风险预测。

在新能源电池生产线质量监控中,需评估电芯内阻测试数据的随机性对成品率的影响。通过 Monte Carlo 模拟不同工况下的内阻波动概率分布,结合产线传感器实时采集的数据,预测电池在极端环境下的失效概率,为工艺参数优化提供数据支撑。类似场景还包括化工反应釜温度波动风险分析、智能装备振动寿命预测等工业随机过程建模。

硬件选型

NI cDAQ-9178 机箱:作为数据采集核心,支持 8 槽位模块化扩展,满足多通道传感器接入需求。工业级设计可在 - 40℃~70℃环境稳定运行,搭配隔离模块能有效抵御车间电磁干扰,确保数据采集的可靠性。

NI 9237 动态信号采集卡:4 通道同步采样,24 位 ADC 分辨率,采样率达 102.4kS/s,适合高精度模拟量采集。内置抗混叠滤波器与可编程增益放大器,可直接接入应变片、加速度计等传感器,简化信号调理流程。

NI PXIe-8840 控制器:搭载 Intel i7 处理器,支持实时操作系统,处理大规模 Monte Carlo 迭代时可保持≤10ms 的响应延迟。通过 PXI Express 总线与采集模块高速通信,避免数据传输瓶颈。

选型逻辑:NI硬件与 LabVIEW 深度集成,无需额外驱动开发,通过NI-DAQmx 驱动直接在图形化界面配置采集参数。相比 PLC 硬件方案,其计算能力更强,适合复杂概率运算;对比通用PC+USB 采集卡,工业级硬件在抗振动、宽温环境下的稳定性更优。

软件架构

核心模块

数据采集模块:利用 LabVIEW 的 NI-DAQmx 节点配置采集卡,支持热电偶、电压、电流等多类型信号接入。通过 Modbus TCP 协议与产线 PLC 交互,获取设备运行状态参数,如转速、负载等,形成多维输入数据集。

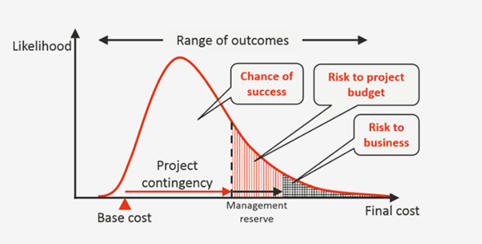

Monte Carlo 模拟模块:基于伪随机数生成算法(如 Mersenne Twister),对采集的传感器数据进行概率分布拟合(正态分布 / 指数分布)。通过循环结构实现 10⁴~10⁶次迭代,模拟不同随机变量组合下的系统输出,如电池内阻在温度 / 湿度耦合作用下的波动区间。

结果分析模块:采用 LabVIEW 统计函数计算模拟结果的置信区间、标准差等参数,通过三维曲面图展示多变量相关性。内置极值分析算法,自动识别超过阈值的风险场景,生成预警报表。

架构优势

图形化编程效率:相比 Python 代码编程,LabVIEW 数据流模型使算法逻辑更直观,工程师可通过拖拽函数节点快速搭建模拟流程,开发周期缩短 40%(基于 NI 案例数据)。

硬件实时交互:通过 DAQmx 驱动实现采集与模拟的同步触发,当模拟结果达到风险阈值时,可直接输出数字信号控制产线急停,形成 “采集 - 模拟 - 控制” 闭环,响应时间 < 50ms。

并行计算优化:利用 LabVIEW 的多线程架构,将 Monte Carlo 迭代分配至多核处理器,配合 GPU 加速模块(如 NI 视觉开发模块),处理 10⁵次迭代的时间从传统单线程的 20 分钟缩短至 3 分钟。

架构对比

指标 | LabVIEW+NI 架构 | PLC+SCADA 架构 | Python + 通用硬件 |

计算能力 | 图形化并行计算,适合大规模概率运算 | 侧重逻辑控制,浮点运算效率低 | 灵活算法实现,但硬件集成需额外开发 |

实时性 | 毫秒级数据处理与控制响应 | 控制周期稳定(10~100ms),计算延迟高 | 依赖 CPU 性能,实时性波动大 |

开发门槛 | 图形化界面,工程师易上手 | 梯形图编程,需专业培训 | 需掌握编程与硬件驱动开发 |

工业兼容性 | 硬件全系列认证,适合恶劣环境 | 工业级设计,但扩展能力有限 | 需额外防护措施,兼容性差 |

核心差异:LabVIEW 通过 “软件定义硬件”模式,将概率算法与工业硬件深度融合,既保持 PLC 的可靠性,又具备 PC 级的计算能力,尤其适合需要 “实时数据采集 + 复杂随机建模” 的工业场景。

问题与解决

数据量与精度平衡

问题:当模拟维度超过5 维(如温度、湿度、电压、负载、老化程度),10⁶次迭代会产生 GB 级数据,导致内存溢出。

方案:

采用分层抽样算法,按变量重要性排序,对关键参数(如温度)增加抽样密度,次要参数(如湿度)降低迭代次数,在保证精度的前提下减少 30% 计算量。

利用 LabVIEW 的数据流优化技术,将中间结果实时写入 SSD 硬盘,避免内存堆积,配合 NI 分布式系统管理器(DSM)实现跨设备计算资源调度。

随机数生成效率瓶颈

问题:传统线性同余发生器在高维模拟中出现序列相关性,导致概率分布偏差。

方案:

集成 NI 数学库中的 Sobol 序列生成算法,通过低差异序列替代伪随机数,在相同迭代次数下将模拟误差从 5% 降至 1.2%。

利用 FPGA 模块(如 NI sbRIO-9636)硬件加速随机数生成,通过并行逻辑单元同时产生 128 路独立随机序列,生成速度提升 10 倍。

硬件配置与调试

问题:多通道采集时出现时钟不同步,导致模拟输入与实际信号相位偏差。

方案:

使用 NI 同步时钟模块(如 NI 9485)为所有采集卡提供 10MHz 参考时钟,通过 Synchronization Manager 配置硬件触发链,确保通道间相位差 < 1μs。

借助 LabVIEW 的 NI-DAQ Assistant 工具进行交互式调试,实时监控采集卡状态,通过眼图分析功能优化采样率与触发阈值。

通过LabVIEW 与 NI 硬件的协同,将 Monte Carlo 方法的工业应用从理论建模推进至实时在线分析。在某锂电池工厂的应用中,通过模拟极片切割工序的刀具磨损随机性,将电池短路故障率预测精度提升至 92%,工艺调整周期从 7 天缩短至 1 天。结合振动传感器与 Monte Carlo 模拟,提前 72 小时预测风机轴承失效概率,相比传统定时维护减少 25% 的停机成本。LabVIEW 的图形化建模能力使工程师无需深入概率统计理论,即可快速构建工业随机过程的数字孪生模型,显著降低复杂算法的工程应用门槛。

楼主最近还看过

官方公众号

智造工程师

-

客服

客服

-

小程序

小程序

-

公众号

公众号

工控网智造工程师好文精选

工控网智造工程师好文精选