LabVIEW下AI开发 点击:227 | 回复:0

在LabVIEW 中集成 AI 功能可通过内置工具或第三方框架实现,满足从简单分类到复杂图像识别的工业需求。以下方案结合开发效率与性能,提供适配不同场景的 AI 集成路径。

一、核心方案原理与对比

1. LabVIEW 内置机器学习工具(Machine Learning Toolkit)

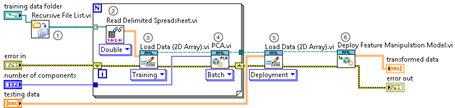

原理:通过图形化界面配置线性回归、决策树、基础神经网络等算法,直接在 LabVIEW 环境内完成数据导入、特征提取、模型训练及部署。

应用:适用于中小规模数据集的基础分类 / 预测任务(如传感器数据模式识别)。

优势:

纯 LabVIEW 生态,无需跨平台编程;

可视化流程设计,工程师易上手;

快速集成至实时控制系统。

局限:深度学习支持有限,无法处理复杂图像特征;

模型训练效率低,依赖内置算法,灵活性不足。

2. 调用 Python / 第三方 AI 框架

原理:通过LabVIEW 的 Python 节点或 DLL 接口,调用TensorFlow/PyTorch 等框架训练的模型,实现图像识别、目标检测等复杂AI 任务。

应用:适用于需要深度神经网络(如 CNN、Transformer)的场景(如工业视觉检测、根系形态分析)。

操作流程:

在 Python 中完成数据预处理、模型训练及验证;

通过 LabVIEW 节点传递图像数据至 Python 模型,获取预测结果。

优势:

复用成熟 AI 生态,支持最先进模型;

灵活处理高维数据,适合复杂特征提取。

局限:需同时掌握 LabVIEW 与 Python,开发门槛较高;

数据传输存在延迟,需优化接口性能;

部署时需确保目标设备安装 Python 运行环境。

3. 预训练模型部署(NI Vision AIDeployment Toolkit)

原理:在Python 中训练模型并导出为 ONNX/TensorRT 格式,通过 LabVIEW 工具包直接部署,专注推理阶段集成。

应用:适用于边缘端实时推理(如嵌入式工控机、智能设备)。

操作流程:

Python 训练模型并导出为标准格式(如 ONNX);

LabVIEW 导入模型,配置输入输出参数,集成至 VI 程序。

优势:

分离训练与部署流程,聚焦工业控制场景;

支持模型量化优化,提升边缘端推理速度;

兼容 NI 实时系统(如 CompactRIO),确保毫秒级响应。

局限:需掌握模型转换技术,调试流程较复杂;

依赖第三方框架完成训练,无法在 LabVIEW 内迭代模型。

二、典型应用场景与选型建议

场景 1:简单分类与实时控制

需求:传感器数据实时分类(如设备状态预警)。

方案:选择 LabVIEW 内置工具。

优势:开发周期短,直接集成至实时循环(Timed Loop),确保控制逻辑与 AI 推理同步。

场景 2:复杂图像识别(如根系分类)

需求:基于图像的根系类型识别与形态参数测量。

方案:Python 训练 + LabVIEW 部署(推荐 ResNet+YOLO 模型)。

实施要点:

Python 中用数据增强(旋转、缩放)扩充根系图像数据集;

导出 ONNX 模型后,通过 LabVIEW 视觉模块实现图像预处理与推理结果可视化。

场景 3:边缘端高性能推理

需求:工业现场毫秒级响应(如流水线缺陷检测)。

方案:预训练模型部署 + 硬件加速(如 NVIDIA Jetson)。

优化手段:

使用 TensorRT 对模型量化(INT8 推理),提升 GPU 计算效率;

通过 LabVIEW Real-Time 模块调度任务优先级,确保推理线程抢占资源。

三、性能优化与系统集成

1. 实时性优化

数据传输:采用内存映射文件(Memory-Mapped Files)或共享变量(Shared Variable)减少 Python 与 LabVIEW 间数据拷贝延迟。

并行处理:多线程设计(图像采集、AI 推理、控制输出分离),避免单线程阻塞。

2. 工业系统集成

控制闭环:将 AI 识别结果作为 PID 控制参数,例如根据根系健康状态自动调节灌溉量。

通信协议:通过 OPC UA 或 Modbus 将 AI 结果上传至 SCADA 系统,或与 PLC 实时交互。

人机界面:在 LabVIEW HMI 中设计可视化看板,显示识别准确率、实时图像及参数曲线。

四、利弊总结与工程师选型建议

方案 | 开发效率 | 模型能力 | 部署复杂度 | 适合阶段 |

内置工具 | ★★★★☆ | ★★☆☆☆ | ★★☆☆☆ | 原型验证、简单任务 |

调用 Python 框架 | ★★☆☆☆ | ★★★★☆ | ★★★☆☆ | 复杂模型开发 |

预训练模型部署 | ★★★☆☆ | ★★★★☆ | ★★★★☆ | 产品化、边缘部署 |

建议:

入门首选内置工具验证可行性;

复杂 AI 任务采用 “Python 训练 + LabVIEW 部署” 组合;

工业级产品优先考虑 ONNX 部署方案,结合 NI 实时硬件确保可靠性。

通过上述方案,工程师可在LabVIEW 平台高效集成 AI 功能,平衡开发成本与系统性能,满足工业自动化、智能检测等场景的核心需求。

官方公众号

智造工程师

-

客服

客服

-

小程序

小程序

-

公众号

公众号

工控网智造工程师好文精选

工控网智造工程师好文精选